目的:用于大三上的《人工智能基础》课程的复习,重点在后半期的“机器学习”部分

Notes:

1.概率计算两个规则

Sum rule

Product rule

2.特征提取:输入数据转化为向量X的过程

3.两个模型

回归模型

分类模型

4.回归树的最优划分 动态规划

Chapter0 绪论

1.AI历史

第一次浪潮:搜索技术、知识表示、确定性推理、感知机

第一次寒冬:感知机模型局限、复杂度NP

第二次浪潮:专家系统、不确定性推理、神经网络BP

第二次寒冬:维护成本高

2.机器学习三要素

优化目标建立:基于数据,计算目标函数最小的模型w

优化求解过程

模型预测过程

3.ML概述

标签学习

分类回归思想建模(最小化回归误差、最小化分类信息熵)

决策树、回归树、GBRT

概率思想建模(最大化数据似然)

逻辑回归、朴素贝叶斯

集成方法

Bagging、Adaboost

结构学习

概率图模型(条件独立假设)

有向图

无监督(隐变量与EM)

PLSA

混合高斯

有监督

朴素贝叶斯

逻辑回归

概率矩阵分解

无向图

条件随机场

神经网络(NN是计算流程的可视化)

前馈NN、RNN(序列标注、机器翻译、对话生成)、CNN

前沿研究

闲聊机器人

Chapter1 单变量学习(标签学习)

一 决策树

1.信息熵

定义 已知随机变量Y的分布P(Y),度量“预测随机变量Y的取值”的难度

香农信息熵

条件信息熵 度量“在随机变量X的前提下,预测随机变量Y”的难度

信息增益 度量X对预测Y的能力

2.构造决策树

准则

分类准确

树结构简单(数节点数少,叶节点的预测值绝对值小)

贪心算法:以最大化IG,即最小化条件熵的目的选择根节点属性

H(Y|Xi)哪一个Xi小

3.连续值决策树

4.决策树剪枝

5.对应ML三要素

目标函数:落入叶节点的样本的信息熵均值最小

优化过程:以条件熵为准则的贪心算法,不可导

模型预测:给定新样本,以落入的叶节点的类别为预测值

二 回归树

1.如何确定叶节点的wj – 目标函数

推导目标函数

从数据的角度->从树的角度

当叶节点为 时目标函数最小

2.如何分裂树的节点 – 优化过程

分裂前

分裂后

要减少量 尽量大

也是贪心策略

三 GBRT

1.GBRT Gradient Boost Regression Tree

渐进梯度回归树

GBDT 渐进梯度决策树

MART Multiple Additive Regression Tree多决策累加回归树

基本假设:多个回归树相加

2.目标函数

设有K棵树

最小化 训练误差+模型复杂度

3.优化过程

贪心:考虑树的添加过程

设前t-1棵树都算出了,预测值为〖y ̂_i〗^((t-1) ),则〖y ̂_i〗^((t) )=〖y ̂_i〗^((t-1) )+f_t (x_i)

相当于构建一棵(xi, yi-〖y ̂_i〗^((t-1) ))的回归树

极值点取法和上一节一样

4.Hw:最佳的k划分

5.模型预测

四 LR 逻辑回归

1.Sigmoid函数

2.目标函数

最大化目标似然

转化为最小化

3.优化过程 梯度下降

最小化,往梯度的反方向走

梯度下降变体:MiniBatch

随机选择部分样例并计算梯度

4.线性回归 vs 逻辑回归

目标函数:

分类平面:

LR对异常点更加robust

共同点:都是线性分类器

5.正则化

目的:目标函数考虑自身权重带来的影响,避免权重太多太大,过拟合

6.特征工程师

套路:决策树+随机森林+GBDT+线性回归

特征非线性临界点划分、不同种类特征的自动组合

五 NB 朴素贝叶斯

1.求p(y|x)的方法

p(y│x)=p(y│x^1,x^2,⋯x^m )=(p(x^1,x^2,⋯x^M│y)p(y))/p(x^1,x^2,⋯x^M ) ∝p(x^1,x^2,⋯x^M│y)p(y)

= p(x^1 │y)⋯p(x^M│y)p(y)条件独立性假设

2.拉格朗日乘数法

证明按频率选可以得到极值

3.连续值

设xj为连续值,通常假设p(xj|y)服从正态分布

六 Ensemble 集成学习

1.策略:改变数据集

Bagging:Bootstrap取样,即有放回

没被采样的概率

Random Forests

随机造K个树:属性选取随机,属性划分随机

那些取样随机的树会被处理为噪声

2.策略:改变算法(权值)

Boosting: Adaboost

训练误差的上界

Chapter 2 结构学习

七 概率图模型

1.定义

节点:随机变量

边:随机变量的关系

2.分类

有向边:贝叶斯网络

无向边:马尔科夫随机场

3.转换:

有向图到全概率公式、公式到有向图

任意概率式子,都可借助sum rule变成p(node|pa)的形式

4.盘子模型

5.条件独立

若 则称

等价形式:

6.概率图转化为条件独立

Tail to tail 成立

Head to tail 成立

Head to head 不成立

考虑A与B之间的每条(无向)路径,若A与B之间的每条路径都被“阻断”,那么:条件独立成立;反之,不成立。

定义:“A与B之间的某条路径”被阻断,当且仅当,这条路径中存在某个节点满足如下两个条件之一

这个节点在集合C中,且它呈现head-to-tail或tail-to-tail的模式

它呈现head-to-head的模式,且它和它的所有子孙节点都不在C中

八 概率矩阵分解

1.电影评分的概率图模型

见笔记

2.目标函数

见笔记

九 共现矩阵

1.共现矩阵的推导

2.主题模型PLSA

D->Z->W

隐变量Z有k个取值

需要学习的参数N +NK+KM

推导:EM算法(很重要)

3.引入隐变量的目的:获得可观察变量和隐变量的关系

十 混合高斯模型

1.模型输入输出

2.方法论:概率图建模

总结随机变量、引入隐变量、建立图模型、EM求解

十一 条件随机场

1.无向图概率图模型

分解

条件独立

2.CRF

十二 神经网络

1.实际的观点:神经网络以图形化的方式刻画出从输入到输出的计算过程

2.RNN应用

序列标注

PartOfSpeech标注;分词

翻译系统

核心技术:短语对齐

词嵌入:词->向量

注意力机制Scoring:前面的字词不能忘

对话系统

多机制建模(回答的丰富性)

要求:可控(安全)、流畅、相关

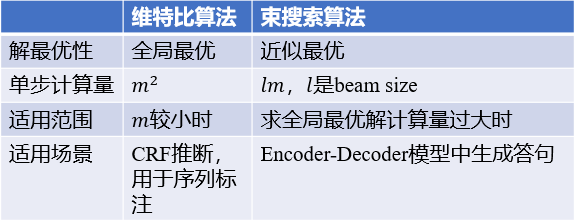

3.Viterbi vs. BeamSearch(RNN)